인공지능(AI)은 더 이상 특정 전문가만의 영역이 아닙니다. 이미 우리는 AI로 만든 번역기, 추천 알고리즘, 자율주행차, 이미지 생성 모델, 챗봇 등을 매일 사용하고 있으며, 앞으로의 기술은 더 많은 부분이 AI 기반으로 작동할 것입니다.

그러나 겉으로 보이는 기술 뒤에는 반드시 수학이 있습니다. 특히 AI의 기반이 되는 수학 정리 중에서도 미분(변화율), 선형대수(벡터·행렬 연산), 경사하강법(최적화 알고리즘)은 거의 모든 인공지능 모델에서 공통적으로 사용됩니다.

이번 글에서는 AI가 어떤 원리로 학습하고, 최적의 판단을 내리며, 패턴을 인식하게 되는지를 수학적 정리를 중심으로 구체적으로 살펴봅니다. 수학을 통해 AI의 구조를 이해하면, 기술이 ‘보이는 언어’로 바뀝니다.

1. 미분 – AI의 학습 방향을 결정짓는 도구

정의: 미분은 함수의 변화율을 나타내는 수학적 기법입니다. 수식으로는 다음과 같이 정의됩니다:

f′(x) = limh→0 (f(x+h) − f(x)) / h이는 한 점에서의 순간적인 증가율을 의미합니다. 즉, 입력값이 조금 변했을 때 결과값이 얼마나 변하는지를 측정하는 도구입니다.

AI와의 연결:

- AI 모델의 ‘학습’은 예측값과 실제값의 차이를 줄이는 과정입니다.

- 이때 손실 함수(Loss Function)를 최소화하려면, 기울기(gradient)가 필요합니다.

- 기울기는 미분의 결과이며, 파라미터(가중치) 조정을 위한 방향성을 제시합니다.

주요 적용 분야:

- 회귀 분석: 오차 제곱의 합(MSE)을 미분하여 최적 가중치 찾기

- 신경망(Neural Network): 각 노드의 활성화 함수(sigmoid, ReLU 등)를 미분하여 역전파(Backpropagation) 수행

- 로지스틱 회귀: Cross-Entropy Loss의 도함수 계산으로 경사하강법 적용

핵심 개념 정리: AI 모델은 미분을 통해 ‘오차가 가장 빨리 줄어드는 방향’을 탐색하며 학습합니다. 이러한 미분 계산이 없으면, AI는 무엇이 잘못되었는지도 모른 채 무작위로 움직이게 됩니다.

2. 선형대수 – 데이터를 수치로 표현하고 조작하는 구조

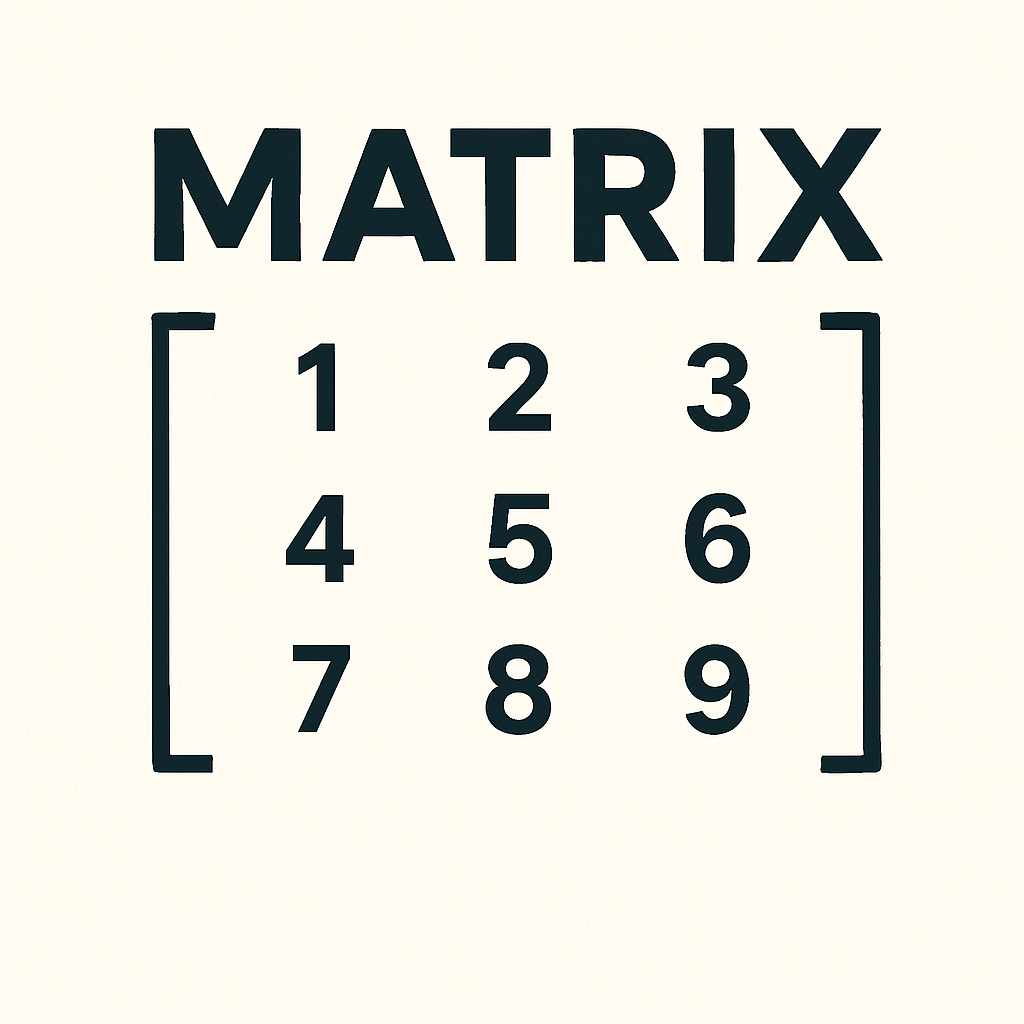

정의: 선형대수는 벡터와 행렬을 중심으로 수학적 연산을 수행하는 학문입니다. 이 구조는 컴퓨터가 데이터를 ‘숫자 덩어리’로 다룰 수 있게 해주는 기반입니다.

기초 개념:

- 벡터: 하나의 데이터를 다차원 수치로 표현한 것 (예: 이미지, 문장)

- 행렬: 여러 벡터를 나열한 구조 (예: 데이터셋, 가중치 집합)

- 행렬 연산: 벡터 간 내적, 외적, 선형 변환, 정규화 등

AI에서의 역할:

- 신경망에서는 입력값과 가중치가 모두 행렬이며, 각 층의 연산은 행렬곱으로 계산됩니다.

- 자연어처리(NLP)에서는 단어를 벡터 공간에 매핑하고, 문장 간 유사도를 벡터 내적으로 계산합니다.

- 이미지 처리에서는 각 픽셀 값을 행렬로 구성하여 CNN(합성곱 신경망) 구조에 활용됩니다.

실제 사용 예:

- Word2Vec: 단어 간 의미 관계를 고차원 벡터로 표현

- PCA(주성분 분석): 차원 축소를 통해 데이터 시각화 및 노이즈 제거

- 특잇값 분해(SVD): 추천 시스템에서 사용자-아이템 관계 분석

핵심 개념 정리: AI는 데이터를 '벡터화'해서 계산합니다. 선형대수는 AI가 데이터를 이해하고, 구조화하며, 패턴을 찾는 방식의 수학적 뼈대입니다.

3. 경사하강법 – AI가 스스로 최적의 값을 찾아가는 길

정의: 경사하강법(Gradient Descent)은 다변량 함수의 최솟값을 찾기 위한 수치 최적화 알고리즘입니다. 현재 위치에서 손실 함수의 기울기를 따라 내려가면서 가장 작은 값을 찾는 방식입니다.

수학 구조:

θ ← θ − α × ∇L(θ)- θ: 학습 파라미터 (가중치, 편향)

- α: 학습률 (Learning Rate)

- ∇L(θ): 손실 함수의 기울기 (Gradient)

AI에서의 활용:

- 딥러닝 모델의 모든 파라미터는 경사하강법으로 최적화됩니다.

- 모델이 학습 데이터를 기반으로 예측을 수행한 뒤, 오차를 계산하고, 이를 줄이기 위해 파라미터를 조정합니다.

변형 알고리즘:

- SGD (Stochastic Gradient Descent): 한 번에 하나의 데이터 샘플로 학습

- Momentum: 관성 개념을 도입해 진동을 줄이고 빠르게 수렴

- Adam: 학습률 자동 조정 기능이 있어 학습 안정성이 뛰어남

응용 사례:

- 자율주행 AI의 경로 예측 모델 학습

- 이미지 생성 모델(GAN)의 손실 함수 최소화

- 음성인식에서 예측과 실제 음성 간의 오차 최소화

핵심 개념 정리: 경사하강법은 AI가 오차를 기준으로 스스로 판단을 개선하고, 반복적으로 최적의 상태에 도달하게 만드는 학습 엔진입니다.

결론 – AI의 뇌는 수학으로 만들어진다

AI가 ‘학습한다’는 것은 단순한 데이터 저장이 아니라, 수학적 최적화와 패턴 해석의 반복적 결과입니다. 미분은 변화의 방향을 알려주고, 선형대수는 구조화된 표현을 가능하게 하며, 경사하강법은 점점 더 정답에 가까운 방향으로 이동하게 만듭니다.

이러한 수학 정리들은 단순한 기술의 바탕을 넘어, 인간의 지능과 문제 해결 능력을 모방하는 구조를 만들어냅니다. 수학이 없으면 인공지능도 없습니다. AI의 본질은 알고리즘이 아닌, 수학 위에 쌓인 논리 체계입니다.

AI를 깊이 있게 이해하고자 한다면, 코드를 배우기 전에 수학을 먼저 배우세요. 수학은 AI의 언어이자, 디지털 세계를 설계하는 지능의 원천입니다.